AI芯片时代即将来临

AI芯片时代即将来临

AI的推动力

第一批电子设备是用木板制造的,人们在木板上用电线和引脚将元件连接到一起。它们需要专业人员纯手工打造,一天最多也就制作十几个电路板。

随着技术的进步和印刷电路板(PCB)的出现,技术水平较低的工人也可以制作电路板了。技术的重大进步,常常会伴随着产品产量增长和制造成本降低。

人工智能(AI)是一个非常宽泛的概念,许多工程师对其确切含义持不同意见。但是,它通常与机器学习(ML)同时出现。机器学习能够让计算机通过接收信息,分析信息并从中学习,然后不断改进其响应。

例如我们可以通过向AI系统展示许多不同的单词图片,并告诉它这些单词是什么,来训练它识别所写单词。AI的这种学习能力已经集成到了许多产品当中,包括安全系统、汽车安全功能、语音识别,甚至是内容审查。

在智能手机和台式电脑等设备上运行简单的AI程序(比如文字识别)很简单,但更先进的系统呢?如何在城市层面进行面部识别?如何管理生产线并使其利润最大化?

随着对AI需求的不断增加,运行AI软件的专用硬件可能变得必不可少。那么,目前AI系统是如何训练的呢?

目前AI是如何训练的?

非资源密集型的小型AI系统(手写识别等),通常可以在标准台式PC和移动设备上实现,但是功能是受限的,因为只有经过大量训练的AI系统才会实用。这里有一个问题AI的典型案例,那就是手写识别,尽管Fujistu近来将中文字符的识别率提高到了96.7%,但这仍然意味着,每写入100个字,就需要用户自己纠正其中的4个字,而单拿本段来说,就已经超过100个字了。

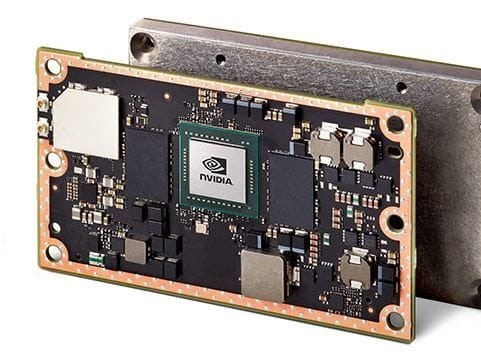

在CPU上运行AI算法和完成深度学习可能是一项资源密集型任务,这使得许多设计师转向了图形处理单元(GPU)。与CPU不同,GPU是设计用来解决复杂矩阵和多项式的,这与AI系统(特别是在处理面部识别等基于图像的AI系统)需要解决的问题类似。 英伟达(Nvidia)已经认识到了GPU在AI领域的重大作用,它推出了目前速度最快,功效最高的嵌入式AI模块------Jetson TX2模块。该模块包括HMP Dual Denver 2/2MB L2 + Quad Arm A57 CPU,4K x 2K视频编码器/解码器和8 GB 128位LPDDR4。它还包括适用于硬件开发者的各种外设,包括5个UART端口、3个SPI端口、8个I2C端口、7个USB端口、SATA、以太网和HDMI。

Jetson TX2模块。 图片来源:Arrow。

如果机器在本地运行AI的话,遇到最大的问题是没有足够的数据来进行学习。这是许多AI解决方案适用于云端的原因;也就是说,这些AI算法运行在具有数百个GPU和CPU的大型计算机上。当数以百万的用户与AI交互时,它可以从每次交互中学习,通过学习后,它可以提供更加可靠和准确的结果。但是,这些AI系统使用的并非专为AI设计的设备。

AI解决方案

随着AI在人们的日常生活中越来越常见,不久之后它将被整合进物联网中,专门的AI设备就有了巨大的市场。但这些专用设备将如何制作?目前是否有现成产品呢?

目前,没有专门的AI硅设备(例如AI CPU)是有很多原因的。首先,实际应用中使用的AI系统基本都能在CPU和GPU等通用芯片上运行;不过,这并不意味着这些芯片也能应对未来的AI问题。

其次,虽然大多数AI算法采用某种形式的深度学习来改善输出,但是深度学习的实现方法有很多种。这意味着AI应用的硬件解决方案可能需要包含动态重新编程和重新配置的元素。

现场可编程门阵列(即FPGA)可能是AI问题的潜在解决方案。FPGA由数百万个门和逻辑块组成,当芯片关闭时,它们都是隔离的和未连接的(假设是易失型FPGA)。当FPGA启动时,它会加载配置数据,告诉它所有门和块应该如何连接在一起。现在的FPGA已经非常强大,工程师还可以在FPGA内配置包含内部RAM和程序存储器的32位Arm CPU。那么,这与AI有什么关系呢?

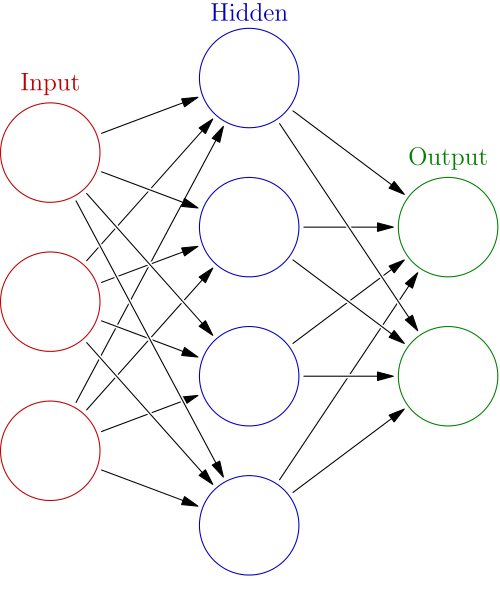

神经网络是实现AI的一种常用方法,其构造方式与大脑中的神经元类似。输入层使用加权连接连接到隐藏处理单元层,然后再连接到输出层。

神经网络结构图。 图片来源:维基百科。

与神经网络不同的是,大脑可以通过在神经元之间形成新的连接并打破旧的连接,来改变其物理结构。不过,工程师在使用FPGA设计AI系统时,通过物理改变逻辑块之间的互连来学习。使用逻辑系统而不是软件解决方案的一个主要优点是,定制硬件通常比软件实现更快,特别是在逻辑系统是异步的情况下。

定制AI芯片

尽管定制AI芯片市场规模不大,但很多制造商要么没有开发AI硬件,要么仍处于开发阶段。然而,这并没有阻止一些公司开发自己的硬件!例如,谷歌开发了“张量处理单元”,这是一个专门研究神经网络的AI ASIC。该芯片在Google I/O 2016上推出,专门设计用于谷歌的TensorFlow框架,值得注意的是,它用于机器学习。与CPU和GPU等设备不同,张量处理单元设计用于高容量,低精度计算(低至8位);不过,这对于未来的AI设备来说可能是一个有价值的解决方案。在处理AI时,并行性比任何单个CPU的强大功能都更重要;类似于人类大脑,个体神经元非常简单,但当与1000亿个其他神经元结合时,它们构成了一个人的意识。

当然,谷歌不是唯一一个设计自己的定制AI芯片的人; 阿里巴巴也在设计自己的硬件。2018年4月,阿里巴巴宣布正在设计一款名为Ali-NPU的AI芯片,该芯片的价格比传统芯片(CPU和GPU)低40倍,同时性能与CPU和GPU相比提升了10倍。阿里巴巴推出AI硬件的原因时为了改善它的云服务。 值得指出的是,该公司表示他们的芯片已经可以为所有使用其云端网络人提供服务了。

AI的未来

机器人替代人的体力劳动,计算机防止车祸……人们在日常生活中会越来越多地依靠计算机辅助,很明显,AI将会成为人类社会不可分割的一部分。由于定制AI硬件尚未公布,AI将如何集成到设备中还并不明朗。但从互联网连接变得越来越快,越来越广泛来判断,未来的AI系统可能完全基于云端,也就是说,位于冰岛的一个超级计算机将会解决世界上所有的AI问题。